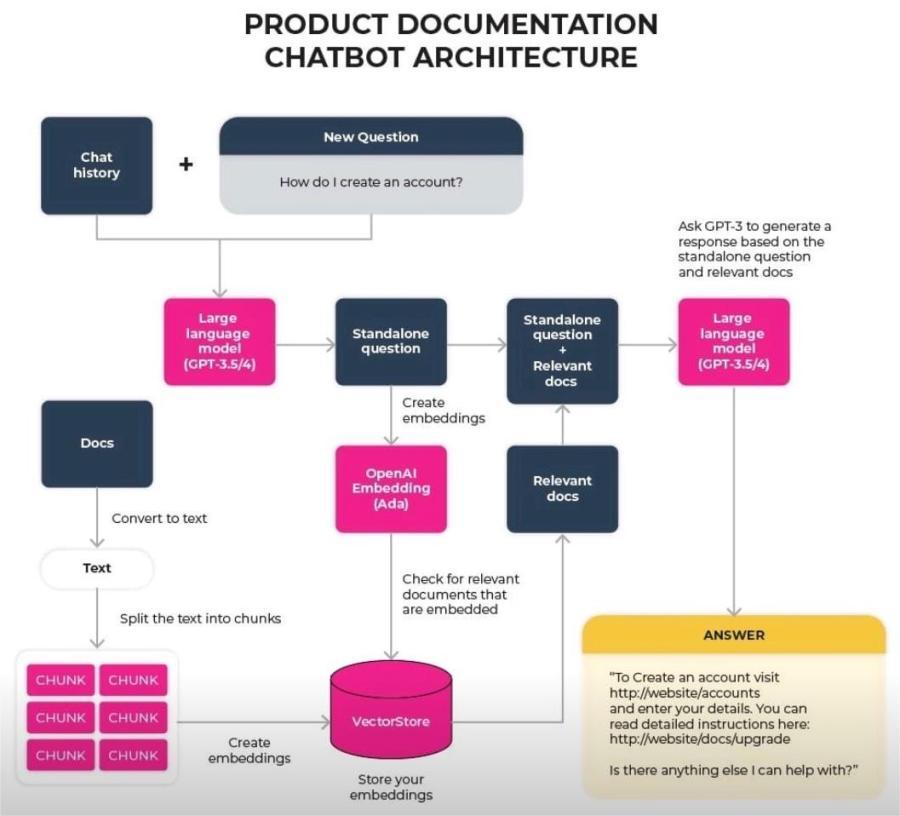

Architecture de l'agent LLM pour une documentation de produit chatbot

Une variation intéressante de l'architecture d'application LLM typique

LLM est utilisé deux fois:

· D'abord pour résumer la conversation jusqu'à présent dans une question autonome

· Ensuite, avec cette question autonome et des documents pertinents pour trouver la réponse

Bien que l'architecture globale suit le flux de travail typique:

· Mine Data / Documents, créez une intégration et enregistrez dans une base de base de vecteur

· Construire des invites pour les requêtes de l'utilisateur ainsi que les documents correspondants récupérés à partir de Vector DB

· Exécutez l'invite en tant qu'inférence sur LLM pré-formé