Métodos de análisis de sentimientos modernos

El análisis de sentimientos (SA) es una aplicación común de los métodos de procesamiento del lenguaje natural (PNL), especialmente la clasificación con el propósito de refinar el contenido emocional del texto.Utilizando métodos como el análisis de sentimientos, los datos cualitativos se pueden analizar cuantitativamente a través de puntajes de sentimientos.Aunque el sentimiento está lleno de subjetividad, el análisis cuantitativo de sentimientos ya tiene muchas funciones útiles, por ejemplo, para que las empresas comprendan cómo los usuarios reaccionan a los productos o discernen el discurso de odio en las revisiones en línea.

La forma más simple de análisis de sentimientos es usar un diccionario que contenga palabras positivas y negativas.A cada palabra se le asigna una puntuación de sentimiento, generalmente +1 para un sentimiento positivo y -1 para negativo.Luego, simplemente agregamos las puntuaciones de los sentimientos de todas las palabras en la oración para calcular la puntuación total final.Obviamente, este enfoque tiene muchos defectos, el más importante de los cuales es que ignora el contexto y las palabras vecinas.Por ejemplo, una frase simple "no buena" tiene un puntaje de sentimiento final de 0, porque "no" es -1 y "bueno" es +1.Una persona normal clasificaría esta frase como una emoción negativa, a pesar de la presencia de "bien".

Otra práctica común es modelar una "bolsa de palabras" en términos de texto.Consideramos cada texto como un vector de 1 a n, donde n es el tamaño de todo el vocabulario.Cada columna es una palabra, y el valor correspondiente es el número de ocurrencias de la palabra.Por ejemplo, la frase "bolsa de palabras" se puede codificar como [2, 2, 1].Este valor se puede utilizar como entrada a los algoritmos de aprendizaje automático, como la regresión logística y las máquinas vectoriales de soporte (SVM) para realizar la clasificación.Esto permite la predicción de sentimientos en datos desconocidos (invisibles).Tenga en cuenta que esto requiere datos con sentimiento conocido para ser entrenados por la moda supervisada.

Aunque es una mejora significativa sobre el enfoque anterior, aún ignora el contexto y el tamaño de los datos con el tamaño del vocabulario.

Word2vec y doc2vec

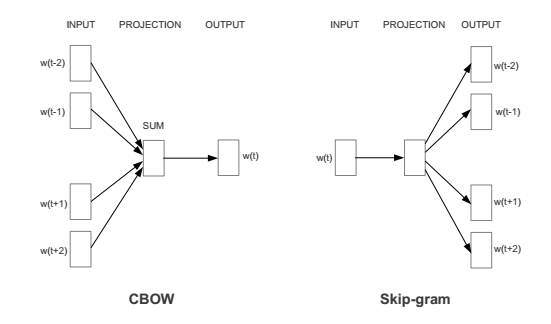

En los últimos años, Google ha desarrollado un nuevo método llamado Word2Vec para capturar el contexto de las palabras al tiempo que reduce el tamaño de los datos.Word2Vec en realidad tiene dos enfoques diferentes: CBOW (bolsa continua de palabras) y Skip-Gram.

Para CBOW, el objetivo es predecir palabras individuales dadas a sus vecinos, mientras que Skip-Gram es lo contrario: queremos predecir una variedad de palabras dadas una sola palabra (ver más abajo).Ambos métodos utilizan redes neuronales artificiales como su algoritmo de clasificación.Primero, cada palabra en el vocabulario es un vector n-dimensional aleatorio.Durante el entrenamiento, el algoritmo utiliza CBOW o Skip-Gram para aprender el vector óptimo para cada palabra.

Estos vectores de palabras ahora pueden tener en cuenta los antecedentes contextuales.Esto puede verse como relaciones de palabras mineras usando ecuaciones algebraicas básicas (por ejemplo, "rey" - "hombre" + "mujer" = "reina").Estos vectores de palabras se pueden usar como entrada a un algoritmo de clasificación para predecir el sentimiento, distinto del enfoque del modelo de la bolsa de palabras.Esto tiene la ventaja de que podemos relacionar las palabras con su contexto y que nuestro espacio de características tiene una dimensionalidad muy baja (generalmente alrededor de 300, en relación con un vocabulario de aproximadamente 100,000 palabras).Después de que la red neuronal haya extraído estas características, también debemos crear una pequeña cantidad de características manualmente.Debido a la longitud variable del texto, el valor promedio de todo el vector de palabras se usa como entrada al algoritmo de clasificación para clasificar el documento completo.

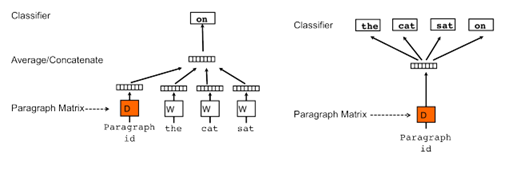

Quoc le y Tomas Mikolov propusieron el enfoque DOC2VEC para caracterizar el texto de diferentes longitudes.Este enfoque es básicamente el mismo que Word2Vec, excepto que el vector de párrafo / documento se agrega al original.También existen dos enfoques: DM (memoria distribuida) y DBOW (bolsa de palabras distribuidas), que intenta predecir palabras individuales dadas las palabras y los vectores de párrafos de la parte anterior.

DBOW usa párrafo para predecir un conjunto aleatorio de palabras en un párrafo (ver más abajo).Una vez entrenado, el vector de párrafo se puede usar como entrada al clasificador de sentimientos sin todas las palabras.